همانطور که انسانها برای طی کردن یک مسیر ناآشنا به تابلوهای راهنما احتیاج دارند، رباتهای گوگل نیز از این قضیه مستثنی نیستند. رباتهای گوگل برای ثبت و شناسایی صفحات، به طور مرتب در صفحات وبسایت شما میخزند. حالا فایل robots.txt چیست؟ این فایل مانند یک تابلو راهنما به رباتها کمک میکند تا مسیر خود را پیدا کنند و به صفحات مرتبط مراجعه کنند.

فایلهای متنی Robots.txt بیشتر برای مدیریت فعالیتهای رباتهای خوب مانند خزندههای وب در نظر گرفته شدهاند، زیرا رباتهای مخرب احتمالاً دستورالعملها را دنبال نمیکنند. شما با استفاده از این فایل میتوانید به رباتهای گوگل اعلام کنید که کدام صفحات را ایندکس یا کراول کنند.

فایل robots.txt چه جوری کار میکنه؟

موتورهای جستجو قبل از رتبهبندی، دو مرحله اصلی را طی میکنند. این دو مرحله عبارت است از:

1) گشتوگذار در فضای وب و پیدا کردن صفحات جدید

2) ثبتکردن صفحات جدید در فهرست گوگل

گوگل برای خزش در صفحات مختلف از رباتهایی استفاده میکند که بهاصطلاح خزنده یا عنکبوت نام دارند. البته معمولاً خزندهها قبل از خزش به دنبال فایل robots.txt میگردند. ازآنجاییکه فایل robots.txt حاوی اطلاعاتی در مورد نحوه خزیدن موتور جستجو است، اطلاعاتی که در آنجا یافت میشود، خزنده را راهنمایی میکند. اگر فایل robots.txt حاوی هیچ دستورالعمل خاصی نباشد و دسترسی آن را محدود نکرده باشید، ربات به خزش در سراسر سایت و سایر اطلاعات ادامه میدهد.

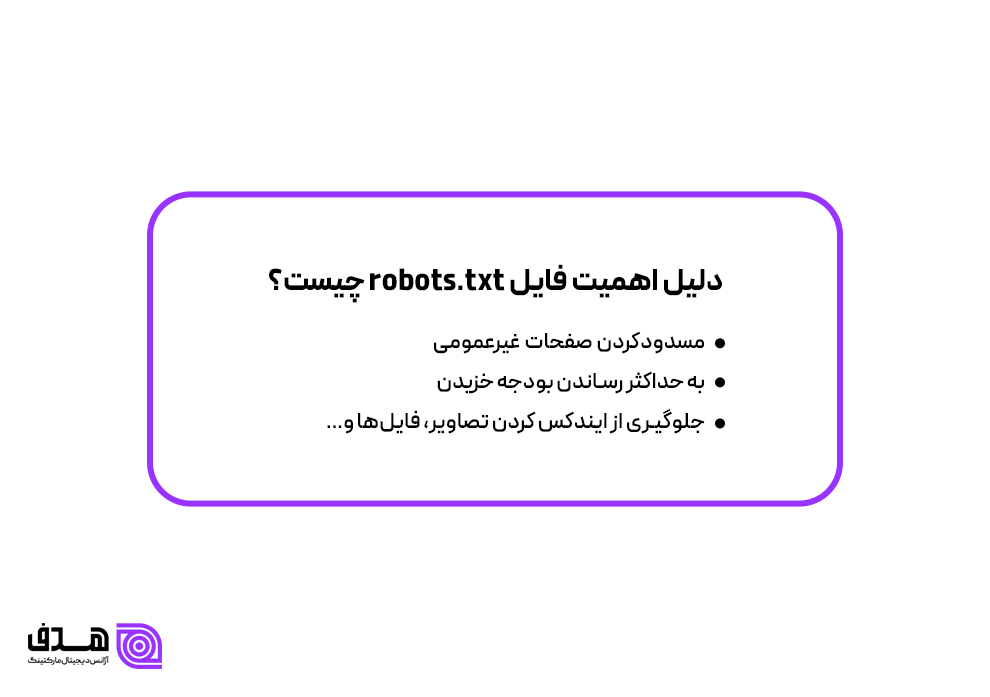

دلیل اهمیت فایل robots.txt چیست؟

اکثر وبسایتها به فایل robots.txt نیاز ندارند، زیرا گوگل معمولاً میتواند تمام صفحات مهم سایت شما را پیدا و ایندکس کند. رباتهای گوگل به طور خودکار صفحاتی را که نسخههای مهم یا تکراری صفحات دیگر نیستند ایندکس نمیکنند. بااینحال، 3 دلیل اصلی وجود دارد که از فایل robots.txt استفاده کنید و آن را در چک لیست سئو قرار دهید.

مسدودکردن صفحات غیرعمومی

گاهی اوقات صفحاتی در سایت خود دارید که نمیخواهید ایندکس شوند. بهعنوانمثال، صفحات ورود ادمین، ثبتنام و پرداخت از این دسته هستند. این یکی از مواردی است که از robots.txt برای مسدود کردن این صفحات استفاده میکنید. با استفاده از این فایل مانع از ورود خزندهها و رباتهای گوگل میشوید.

به حداکثر رساندن بودجه خزیدن

رباتهای گوگل محدود هستند و انرژی یا بودجه مشخصی برای کراول صفحات دارند که به کراول باجت معروف است. به همین خاطر باید صفحات مهم را در اولویت قرار دهید. برای جلوگیری از اتمام بودجه خزش، صفحات بیاهمیت را در فایل robots.txt قرار دهید و به رباتهای گوگل اجازه دهید که انرژی خود را صرف صفحات مهمتر کنند.

جلوگیری از ایندکس کردن تصاویر، فایلها و…

برای جلوگیری از ایندکس شدن صفحات یا مدیا موجود، میتوان از فایل robots.txt یا متاتگهای ربات مانند noindex استفاده کرد. بااینحال، معمولا دستورالعملهای متا برای منابع چندرسانهای، مانند فایلهای PDF و تصاویر، بهدرستی عمل نمیکنند و باید از فایل robots.txt کمک بگیریم.

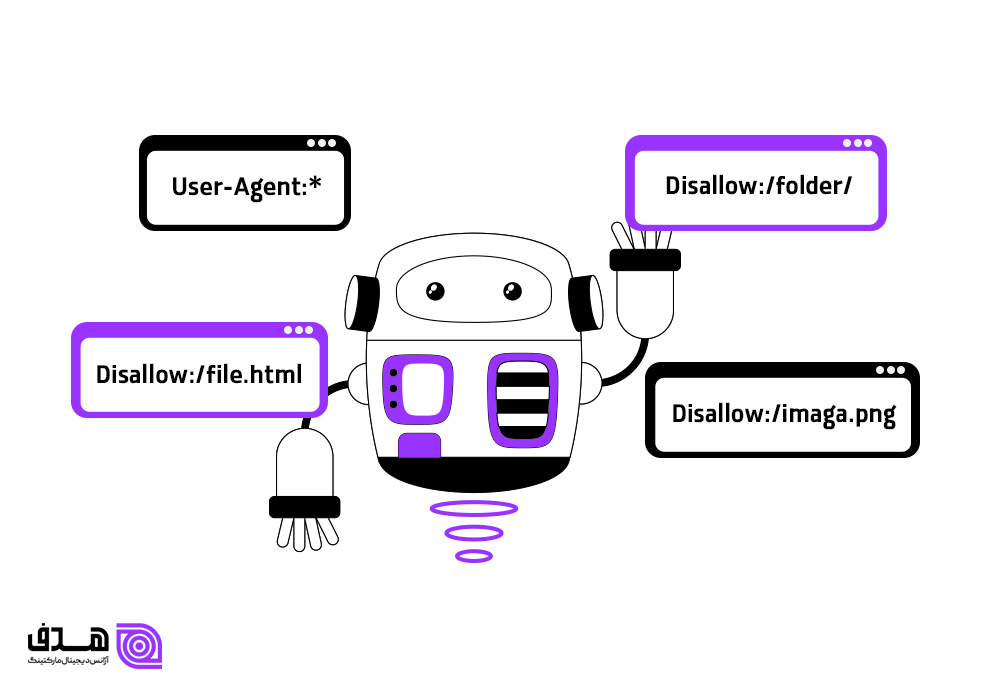

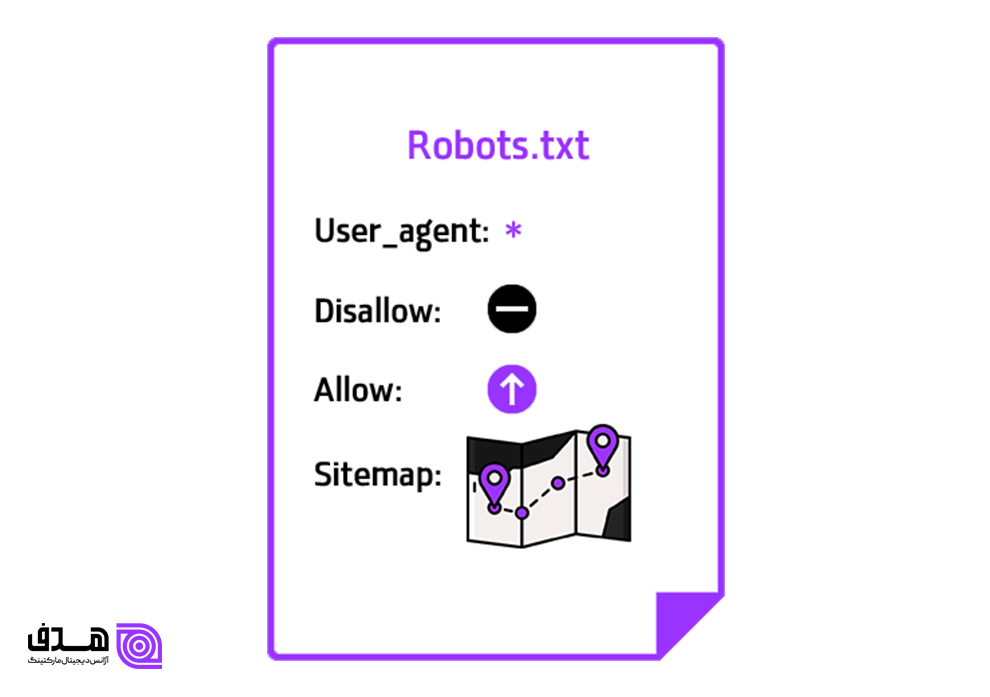

انواع دستورات فایل robots.txt چیست؟

در ادامه چند مورد از مهمترین اصطلاحات و دستورات فایل robots.txt را معرفی میکنیم.

User-agent(عامل کاربر)

عامل کاربر همان ربات خزنده است که دستورالعملهای نوشته شده در فایل را موبهمو میخواند و اجرا میکند که در ادامه معروفترین این دستورالعملها را معرفی میکنیم.

Disallow

این دستور به عامل کاربرد میگوید که یک URL خاص را بررسی نکند و آن صفحه را مورد خزش قرار ندهد. برای اجرای این دستور کافی است که فقط از دستور “Disallow” برای هر URL استفاده کنید.

Allow

رباتهای زیادی وظیفه بررسی صفحات را برعهده دارند، اما این دستور فقط در مورد رباتهای گوگل کارایی دارد. این فرمان، دستوری به سایر رباتها نمیدهد. با نوشتن این دستور برای هر url آن را به رباتهای گوگل معرفی میکنید.

نکته! حتی اگر قبل از دستور allow، از دستور disallow استفاده شده باشد، باز هم قابل خزش و خوانش است.

Sitemap

نقشه سایت یا سایت مپ چیست؟ همانطور که از اسم آن مشخص است، فایلی شامل تمام صفحات و راه و چاههای یک سایت است. در این فایل تمامی صفحات معرفی شدهاند و به خزش سریعتر رباتها کمک میکند. سایت مپ توسط رباتهای Google، Ask، Bing و Yahoo قابلبررسی است.

Crawl-delay

این دستور به رباتها میگوید که برای خزش و کراول کردن هر صفحه باید چقدر منتظر بمانند. البته گفته میشود که این فرمان بر رباتهای گوگل تأثیری ندارد، اما برای بقیه خزندهها قابل خواندن است.

ساخت robots.txt

پس از آشنایی با این فایل حتماً کنجکاو هستید، بدانید که نحوه ساخت فایل robots.txt چگونه است؟ این فایل، مانند یک متن ساده است، پس برای نوشتن میتوانید از یک صفحه word هم استفاده کنید. برای نوشتن دستورات، باید ابتدا عامل کاربر و سپس دستور موردنظر را ایجاد کنید. در ادامه چندین مثال از این فایل را با هم بررسی میکنیم.

User-agent: x

Disallow : y

در اینجا x رباتی است که از انجام کار y منع شده است و آن قسمتها مسدود هستند.

در ادامه با مثال زیر همراه باشید.

User-agent: googlebot

Disallow : images/

این دستور به Googlebot میگوید که پوشه تصویر وبسایت شما را خزش و ایندکس نکند.

نکته: میتوانید از یک ستاره (*) برای صحبت با همه رباتهایی که در وبسایت شما را بررسی میکنند، استفاده کنید. مثال بعدی در مورداستفاده از این نکته است.

User-agent: *

Disallow : images/

در اینجا قصد فایل robots.txt سئو چیست؟ او به همه رباتها دستور میدهد که بخش تصاویر را بررسی نکنند.

مثالهای گفته شده یکی از راههای استفاده از فایل robots.txt است.

روش مشاهده فایل robots.txt چیست؟

فایل robots.txt در هاست در پوشه Public_html قرار دارد؛ برای اینکه مطمئن شوید وجود دارد یا نه، مراحل فوق را دنبال کنید. ابتدا دامنه وبسایت را تایپ کنید، سپس /robots.txt را به انتهای URL اضافه کنید. بهعنوانمثال، فایل روباتهای Moz در moz.com/robots.txt قرار دارد.

اگر صفحه txt. نمایش داده نشد و با خطای 404 مواجه شدید، کلا فایل را ندارید. ولی اگر صفحه سفید نمایش داده شد، باید از بخش هاست، آن را ویرایش کنید. برای ویرایش فایل robots.txt، دو راه وجود دارد. راه اول استفاده از افزونههای رنک مث و یواست و راه دوم دایرکتوری اصلی وبسایت است.

تست فایل robots.txt با گوگل

برای تست سلامت فایل robots.txt میتوانید از ابزارهای مختلفی استفاده کنید، اما بهترین آنها متعلق به گوگل است! با استفاده از این ابزار متوجه میشوید که مشکلات فایل چیست و کجاست؟ برای اعتبار سنجی به این لینک مراجعه کنید و سپس گزینه Open robots.txt Tester را انتخاب کنید. اگر وبسایت خود را به سرچ کنسول گوگل متصل کرده باشید، وارد صفحهای میشوید که آخرین آپدیت از فایل robots.txt و وضعیت آن را نمایش میدهد.

نحوه بهینهسازی فایل robots برای سئو

حتماً تا اینجای مقاله از خود پرسیدهاید که فایده و نحوه بهینهسازی فایل robots.txt چیست؟ شما با استفاده از این فایل میتوانید به بهبود سئو سایت خود کمک کنید. در ادامه نکاتی برای بهینهکردن این فایل معرفی میشود.

· ابتدا مطمئن شوید که محتواهای موجود در سایت قابل خزش هستند. درصورتیکه صفحات قابلبررسی نباشند، امکان بهینهسازی هم وجود ندارد.

· از robots.txt برای جلوگیری از نمایش اطلاعات شخصی در نتایج صفحه جستجو استفاده نکنید. ازآنجاکه صفحات دیگر ممکن است مستقیماً به صفحه حاوی اطلاعات خصوصی لینک داشته باشد، این دستور قابلاجرا نیست. بهتر است برای محافظت از اطلاعات خصوصی از دستورالعمل متا noindex استفاده کنید.

· برخی از موتورهای جستجو دارای چندین ربات خزنده هستند. بهعنوانمثال، Google از Googlebot برای جستجوی ارگانیک و Googlebot-Image برای جستجوی تصویر استفاده میکند. اکثر عوامل کاربر از یک موتور جستجو از قوانین یکسانی پیروی میکنند، بنابراین نیازی به تعیین دستورالعمل برای هر یک از خزندههای متعدد موتور جستجو نیست، اما با نوشتن چندین دستورالعمل، میتوانید نقشه راه دقیقتری به رباتها بدهید.

· یک موتور جستجو محتویات robots.txt را در حافظه پنهان نگه میدارد، اما معمولاً حداقل یکبار در روز مطالب ذخیره شده را بهروز میکند. اگر فایل را تغییر میدهید و میخواهید آن را سریعتر از زمان بررسی گوگل بهروزرسانی کنید، آدرس robots.txt خود را به Google ارسال کنید.

· لینکهای موجود در صفحات مسدود شده توسط robots.txt دنبال نمیشوند. مگر اینکه از سایر صفحات قابلدسترسی موتور جستجو لینک داده شده باشند، منابع پیوند شده در صفحات مسدودی، خزیده نشده و بهاحتمال زیاد ایندکس هم نمیشوند.

فایده فایل robots.txt چیست؟

پس از خواندن این مقاله الان میدانید که فایده، کاربرد و محتوای فایل robots.txt چیست. در اصل این فایل برای رباتهای موتورهای جستجو نوشته میشود و برای کاربران سایت نیست. شما با استفاده از محتوای فایل robots.txtدرخواستهای خود را به رباتها اعلام میکنید. معمولا این درخواستها شامل نحوه ورود یا عدم اجازه برای ورود و خواندن یک صفحه است. بهتر است برای نوشتن این فایل از یک سئوکار مجرب کمک بگیرید. اگر در نوشتن فایل روبوت به مشکلی برخوردید یا با خطا مواجه شدید، با متخصصان هدف برای خدمات سئو سایت در ارتباط باشید.